Dalam pemodelan statistik , analisis regresi adalah seperangkat proses statistik untuk memperkirakan hubungan antara variabel dependen (sering disebut 'variabel hasil') dan satu atau lebih variabel independen (sering disebut 'prediktor', 'kovariat', atau 'fitur' ). Bentuk paling umum dari analisis regresi adalah regresi linier , di mana seorang peneliti menemukan garis (atau kombinasi linear yang lebih kompleks) yang paling cocok dengan data sesuai dengan kriteria matematika tertentu. Misalnya, metode kuadrat terkecil biasamenghitung garis unik (atau hyperplane) yang meminimalkan jumlah jarak kuadrat antara data yang benar dan garis (atau hyperplane). Untuk alasan matematis tertentu (lihat regresi linier ), ini memungkinkan peneliti untuk memperkirakan ekspektasi bersyarat (atau nilai rata-rata populasi) dari variabel dependen ketika variabel independen mengambil sekumpulan nilai tertentu. Bentuk regresi yang kurang umum menggunakan prosedur yang sedikit berbeda untuk memperkirakan parameter lokasi alternatif (misalnya, regresi kuantil atau Analisis Kondisi yang Diperlukan [1] ) atau memperkirakan ekspektasi bersyarat pada koleksi model non-linear yang lebih luas (misalnya, regresi nonparametrik ).

Analisis regresi terutama digunakan untuk dua tujuan yang berbeda secara konseptual. Pertama, analisis regresi secara luas digunakan untuk prediksi dan peramalan , di mana penggunaannya memiliki tumpang tindih substansial dengan bidang pembelajaran mesin . Kedua, dalam beberapa situasi analisis regresi dapat digunakan untuk menyimpulkan hubungan sebab akibat antara variabel independen dan dependen. Yang penting, regresi sendiri hanya mengungkapkan hubungan antara variabel dependen dan koleksi variabel independen dalam dataset tetap.Untuk menggunakan regresi untuk prediksi atau untuk menyimpulkan hubungan sebab akibat, masing-masing, seorang peneliti harus hati-hati membenarkan mengapa hubungan yang ada memiliki kekuatan prediksi untuk konteks baru atau mengapa hubungan antara dua variabel memiliki interpretasi kausal. Yang terakhir ini sangat penting ketika peneliti berharap untuk memperkirakan hubungan sebab akibat menggunakan data pengamatan . [2] [3]

Sejarah

Bentuk regresi paling awal adalah metode kuadrat terkecil , yang diterbitkan oleh Legendre pada tahun 1805, [4] dan oleh Gauss pada tahun 1809. [5] Legendre dan Gauss menerapkan metode ini pada masalah penentuan, dari pengamatan astronomi, mengorbit benda-benda tentang Matahari (kebanyakan komet, tetapi juga kemudian planet minor yang baru ditemukan). Gauss menerbitkan pengembangan lebih lanjut dari teori kuadrat terkecil pada tahun 1821, [6] termasuk versi teorema Gauss-Markov .

Istilah "regresi" diciptakan oleh Francis Galton pada abad kesembilan belas untuk menggambarkan fenomena biologis. Fenomena itu adalah bahwa ketinggian keturunan leluhur tinggi cenderung mundur ke bawah rata-rata normal (sebuah fenomena yang juga dikenal sebagai regresi menuju rata-rata ). [7] [8] Untuk Galton, regresi hanya memiliki makna biologis ini, [9] [10] tetapi karyanya kemudian diperluas oleh Udny Yule dan Karl Pearson ke konteks statistik yang lebih umum. [11] [12]Dalam karya Yule dan Pearson, distribusi gabungan dari variabel respon dan penjelas diasumsikan sebagai Gaussian . Asumsi ini dilemahkan oleh RA Fisher dalam karya-karyanya tahun 1922 dan 1925. [13] [14] [15] Fisher berasumsi bahwa distribusi bersyarat dari variabel respon adalah Gaussian, tetapi distribusi bersama tidak perlu.Dalam hal ini, asumsi Fisher lebih dekat dengan formulasi Gauss tahun 1821.

Pada 1950-an dan 1960-an, para ekonom menggunakan "kalkulator" meja elektromekanis untuk menghitung regresi. Sebelum 1970, kadang-kadang butuh waktu hingga 24 jam untuk menerima hasil dari satu regresi. [16]

Metode regresi terus menjadi bidang penelitian aktif. Dalam beberapa dekade terakhir, metode baru telah dikembangkan untuk regresi yang kuat , regresi yang melibatkan respons berkorelasi seperti deret waktu dan kurva pertumbuhan , regresi di mana variabel prediktor (variabel independen) atau respons adalah kurva, gambar, grafik, atau objek data kompleks lainnya, metode regresi mengakomodasi berbagai jenis data yang hilang, regresi nonparametrik , metode Bayesian untuk regresi, regresi di mana variabel prediktor diukur dengan kesalahan, regresi dengan lebih banyak variabel prediktor daripada pengamatan, dan inferensial kausal dengan regresi.

model regresi

Dalam praktiknya, para peneliti pertama-tama memilih model yang ingin mereka perkirakan dan kemudian menggunakan metode yang mereka pilih (misalnya, kuadrat terkecil biasa ) untuk memperkirakan parameter dari model itu. Model regresi melibatkan komponen-komponen berikut:

- Parameter yang tidak diketahui , sering dilambangkan sebagai skalar atau vektor

.

- Variabel independen , yang diamati dalam data dan sering dilambangkan sebagai vektor

(dimana

menunjukkan deretan data).

- Variabel dependen , yang diamati dalam data dan sering dilambangkan dengan menggunakan skalar

.

- Istilah kesalahan , yang tidak secara langsung diamati dalam data dan sering dinotasikan menggunakan skalar

.

Dalam berbagai bidang aplikasi , berbagai terminologi digunakan sebagai pengganti variabel dependen dan independen .

Sebagian besar model regresi mengusulkan itu  adalah fungsi dari

adalah fungsi dari  dan

dan  , dengan

, dengan  mewakili istilah kesalahan aditif yang mungkin berlaku untuk penentu un-modeled

mewakili istilah kesalahan aditif yang mungkin berlaku untuk penentu un-modeled  atau noise statistik acak:

atau noise statistik acak:

Tujuan para peneliti adalah untuk memperkirakan fungsi  yang paling cocok dengan data. Untuk melakukan analisis regresi, bentuk fungsi

yang paling cocok dengan data. Untuk melakukan analisis regresi, bentuk fungsi  harus ditentukan. Terkadang bentuk fungsi ini didasarkan pada pengetahuan tentang hubungan antar

harus ditentukan. Terkadang bentuk fungsi ini didasarkan pada pengetahuan tentang hubungan antar  dan

dan  itu tidak bergantung pada data. Jika tidak ada pengetahuan seperti itu tersedia, bentuk yang fleksibel atau nyaman untuk

itu tidak bergantung pada data. Jika tidak ada pengetahuan seperti itu tersedia, bentuk yang fleksibel atau nyaman untuk  terpilih. Sebagai contoh, sebuah regresi univariat sederhana dapat diusulkan

terpilih. Sebagai contoh, sebuah regresi univariat sederhana dapat diusulkan  , menunjukkan bahwa peneliti percaya

, menunjukkan bahwa peneliti percaya  menjadi perkiraan yang masuk akal untuk proses statistik menghasilkan data.

menjadi perkiraan yang masuk akal untuk proses statistik menghasilkan data.

Setelah peneliti menentukan model statistik pilihan mereka, berbagai bentuk analisis regresi menyediakan alat untuk memperkirakan parameter  . Sebagai contoh, kuadrat terkecil (termasuk varian yang paling umum, kuadrat terkecil biasa ) menemukan nilai

. Sebagai contoh, kuadrat terkecil (termasuk varian yang paling umum, kuadrat terkecil biasa ) menemukan nilai  yang meminimalkan jumlah kesalahan kuadrat

yang meminimalkan jumlah kesalahan kuadrat  . Metode regresi yang diberikan pada akhirnya akan memberikan estimasi

. Metode regresi yang diberikan pada akhirnya akan memberikan estimasi  , biasanya dilambangkan

, biasanya dilambangkan  untuk membedakan estimasi dari nilai parameter true (tidak diketahui) yang menghasilkan data. Dengan menggunakan estimasi ini, peneliti kemudian dapat menggunakan nilai pas

untuk membedakan estimasi dari nilai parameter true (tidak diketahui) yang menghasilkan data. Dengan menggunakan estimasi ini, peneliti kemudian dapat menggunakan nilai pas  untuk prediksi atau untuk menilai keakuratan model dalam menjelaskan data. Apakah peneliti secara intrinsik tertarik pada estimasi tersebut

untuk prediksi atau untuk menilai keakuratan model dalam menjelaskan data. Apakah peneliti secara intrinsik tertarik pada estimasi tersebut  atau nilai prediksi

atau nilai prediksi  akan tergantung pada konteks dan tujuannya. Seperti yang dijelaskan dalam kuadrat terkecil biasa , kuadrat terkecil banyak digunakan karena fungsi yang diestimasi

akan tergantung pada konteks dan tujuannya. Seperti yang dijelaskan dalam kuadrat terkecil biasa , kuadrat terkecil banyak digunakan karena fungsi yang diestimasi  mendekati ekspektasi bersyarat

mendekati ekspektasi bersyarat  . [5]Namun, varian alternatif (misalnya, paling tidak penyimpangan absolut atau regresi kuantil ) berguna ketika para peneliti ingin memodelkan fungsi-fungsi lain.

. [5]Namun, varian alternatif (misalnya, paling tidak penyimpangan absolut atau regresi kuantil ) berguna ketika para peneliti ingin memodelkan fungsi-fungsi lain.  .

.

Penting untuk dicatat bahwa harus ada data yang cukup untuk memperkirakan model regresi. Sebagai contoh, anggaplah seorang peneliti memiliki akses ke  baris data dengan satu variabel dependen dan dua independen:

baris data dengan satu variabel dependen dan dua independen:  .Anggap lebih jauh bahwa peneliti ingin memperkirakan model linear bivariat melalui kuadrat terkecil :

.Anggap lebih jauh bahwa peneliti ingin memperkirakan model linear bivariat melalui kuadrat terkecil :  . Jika peneliti hanya memiliki akses ke

. Jika peneliti hanya memiliki akses ke  titik data, maka mereka dapat menemukan banyak kombinasi tanpa batas

titik data, maka mereka dapat menemukan banyak kombinasi tanpa batas  yang menjelaskan data dengan baik: kombinasi apa pun dapat dipilih yang memuaskan

yang menjelaskan data dengan baik: kombinasi apa pun dapat dipilih yang memuaskan  , yang semuanya mengarah ke

, yang semuanya mengarah ke  dan karena itu solusi yang valid yang meminimalkan jumlah residu kuadrat. Untuk memahami mengapa ada banyak pilihan yang tak terbatas, perhatikan bahwa sistem

dan karena itu solusi yang valid yang meminimalkan jumlah residu kuadrat. Untuk memahami mengapa ada banyak pilihan yang tak terbatas, perhatikan bahwa sistem  persamaan harus diselesaikan untuk 3 yang tidak diketahui, yang membuat sistem tidak ditentukan . Atau, seseorang dapat memvisualisasikan banyak pesawat 3 dimensi yang tak terbatas

persamaan harus diselesaikan untuk 3 yang tidak diketahui, yang membuat sistem tidak ditentukan . Atau, seseorang dapat memvisualisasikan banyak pesawat 3 dimensi yang tak terbatas  poin tetap.

poin tetap.

Lebih umum, untuk memperkirakan model kuadrat terkecil dengan  parameter yang berbeda, harus dimiliki

parameter yang berbeda, harus dimiliki  titik data yang berbeda. Jika

titik data yang berbeda. Jika  , maka ada umumnya tidak ada satu set parameter yang akan cocok dengan data. Kuantitas

, maka ada umumnya tidak ada satu set parameter yang akan cocok dengan data. Kuantitas  sering muncul dalam analisis regresi, dan disebut sebagai derajat kebebasandalam model. Selain itu, untuk memperkirakan model kuadrat terkecil, variabel independen

sering muncul dalam analisis regresi, dan disebut sebagai derajat kebebasandalam model. Selain itu, untuk memperkirakan model kuadrat terkecil, variabel independen  harus independen secara linear : seseorang tidakboleh dapat merekonstruksi variabel independen dengan menambahkan dan mengalikan variabel independen yang tersisa. Sebagaimana dibahas dalam kuadrat terkecil biasa , kondisi ini memastikan hal itu

harus independen secara linear : seseorang tidakboleh dapat merekonstruksi variabel independen dengan menambahkan dan mengalikan variabel independen yang tersisa. Sebagaimana dibahas dalam kuadrat terkecil biasa , kondisi ini memastikan hal itu  adalah matriks Invertible dan karena itu solusi

adalah matriks Invertible dan karena itu solusi  ada

ada

Asumsi yang mendasari

Dengan sendirinya, regresi hanyalah perhitungan menggunakan data. Untuk menafsirkan hasil regresi sebagai kuantitas statistik yang bermakna yang mengukur hubungan dunia nyata, peneliti sering mengandalkan sejumlah asumsi klasik. Ini sering termasuk:

- Sampel mewakili populasi pada umumnya.

- Variabel independen diukur tanpa kesalahan.

- Penyimpangan dari model memiliki nilai yang diharapkan dari nol, tergantung pada kovariat:

- Varian dari residu

konstan di seluruh pengamatan ( homoscedasticity ).

- Residu

tidak berkorelasi satu sama lain. Secara matematis, matriks varians-kovarian kesalahan adalah diagonal .

Sejumlah kondisi cukup untuk estimator kuadrat-terkecil untuk memiliki sifat yang diinginkan: khususnya, asumsi Gauss-Markov menyiratkan bahwa estimasi parameter akan tidak bias , konsisten , dan efisien dalam kelas estimator linier yang tidak bias.Praktisi telah mengembangkan berbagai metode untuk mempertahankan beberapa atau semua sifat yang diinginkan ini dalam pengaturan dunia nyata, karena asumsi klasik ini tidak mungkin benar. Misalnya, pemodelan kesalahan-dalam-variabel dapat menyebabkan estimasi yang masuk akal variabel independen diukur dengan kesalahan. Kesalahan standar yang konsisten heteroskedastisitas memungkinkan varians  untuk mengubah nilai lintas

untuk mengubah nilai lintas  . Kesalahan terkait yang ada dalam himpunan bagian data atau mengikuti pola tertentu dapat ditangani menggunakan kesalahan standar berkerumun, regresi geografis tertimbang , atau kesalahan standar Newey-Barat , di antara teknik lainnya. Ketika baris data sesuai dengan lokasi di ruang, pilihan cara memodelkan

. Kesalahan terkait yang ada dalam himpunan bagian data atau mengikuti pola tertentu dapat ditangani menggunakan kesalahan standar berkerumun, regresi geografis tertimbang , atau kesalahan standar Newey-Barat , di antara teknik lainnya. Ketika baris data sesuai dengan lokasi di ruang, pilihan cara memodelkan  dalam unit geografis dapat memiliki konsekuensi penting. [17] [18] Subbidang ekonometrik sebagian besar berfokus pada pengembangan teknik yang memungkinkan para peneliti untuk membuat kesimpulan dunia nyata yang masuk akal dalam pengaturan dunia nyata, di mana asumsi klasik tidak berlaku secara tepat.

dalam unit geografis dapat memiliki konsekuensi penting. [17] [18] Subbidang ekonometrik sebagian besar berfokus pada pengembangan teknik yang memungkinkan para peneliti untuk membuat kesimpulan dunia nyata yang masuk akal dalam pengaturan dunia nyata, di mana asumsi klasik tidak berlaku secara tepat.

regresi linier

Dalam regresi linier, spesifikasi model adalah bahwa variabel dependen,  adalah kombinasi linear dari parameter (tetapi tidak harus linier dalam variabel independen ).Misalnya, dalam regresi linier sederhana untuk pemodelan

adalah kombinasi linear dari parameter (tetapi tidak harus linier dalam variabel independen ).Misalnya, dalam regresi linier sederhana untuk pemodelan  poin data ada satu variabel independen:

poin data ada satu variabel independen:  , dan dua parameter,

, dan dua parameter,  dan

dan  :

:

- garis lurus:

Dalam regresi linier berganda, ada beberapa variabel independen atau fungsi variabel independen.

Menambahkan istilah dalam  regresi sebelumnya memberikan:

regresi sebelumnya memberikan:

- parabola:

Ini masih regresi linier; meskipun ekspresi di sisi kanan kuadratik dalam variabel independen  , itu linear dalam parameter

, itu linear dalam parameter  ,

,  dan

dan

Dalam kedua kasus tersebut,  adalah istilah kesalahan dan subskrip

adalah istilah kesalahan dan subskrip  indeks pengamatan tertentu.

indeks pengamatan tertentu.

Mengembalikan perhatian kami ke kasus garis lurus: Diberikan sampel acak dari populasi, kami memperkirakan parameter populasi dan mendapatkan model regresi linier sampel:

Sisa ,  , adalah perbedaan antara nilai variabel dependen yang diprediksi oleh model,

, adalah perbedaan antara nilai variabel dependen yang diprediksi oleh model,  , dan nilai sebenarnya dari variabel dependen,

, dan nilai sebenarnya dari variabel dependen,  . Salah satu metode estimasi adalah kuadrat terkecil biasa . Metode ini memperoleh estimasi parameter yang meminimalkan jumlah residu kuadrat, SSR :

. Salah satu metode estimasi adalah kuadrat terkecil biasa . Metode ini memperoleh estimasi parameter yang meminimalkan jumlah residu kuadrat, SSR :

Minimalisasi fungsi ini menghasilkan satu set persamaan normal , satu set persamaan linear simultan dalam parameter, yang diselesaikan untuk menghasilkan penduga parameter,  .

.

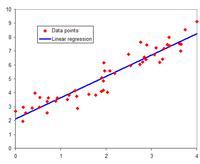

Ilustrasi regresi linier pada set data.

Dalam kasus regresi sederhana, rumus untuk estimasi kuadrat terkecil adalah

dimana  adalah rata - rata (rata-rata) dari

adalah rata - rata (rata-rata) dari  nilai dan

nilai dan  adalah rata - rata dari

adalah rata - rata dari  nilai-nilai.

nilai-nilai.

Dengan asumsi bahwa istilah kesalahan populasi memiliki varians konstan, estimasi varians tersebut diberikan oleh:

Ini disebut mean square error (MSE) dari regresi. Penyebutnya adalah ukuran sampel dikurangi dengan jumlah parameter model yang diperkirakan dari data yang sama,  untuk

untuk  regresi atau

regresi atau  jika intersep digunakan. [19] Dalam hal ini,

jika intersep digunakan. [19] Dalam hal ini,  jadi penyebutnya

jadi penyebutnya  .

.

Kesalahan standar estimasi parameter diberikan oleh

Di bawah asumsi lebih lanjut bahwa istilah kesalahan populasi terdistribusi secara normal, peneliti dapat menggunakan perkiraan kesalahan standar ini untuk membuat interval kepercayaan dan melakukan tes hipotesis tentang parameter populasi .

Model linear umum

Dalam model regresi berganda yang lebih umum, ada  Variabel independen:

Variabel independen:

dimana  adalah

adalah  -Pengamatan pada tanggal

-Pengamatan pada tanggal  variabel independen -th. Jika variabel independen pertama mengambil nilai 1 untuk semua

variabel independen -th. Jika variabel independen pertama mengambil nilai 1 untuk semua  ,

,  , kemudian

, kemudian  disebut intersep regresi .

disebut intersep regresi .

Estimasi parameter kuadrat terkecil diperoleh dari  persamaan normal. Sisa dapat ditulis sebagai

persamaan normal. Sisa dapat ditulis sebagai

Persamaan normal adalah

Dalam notasi matriks, persamaan normal ditulis sebagai

Dimana  elemen dari

elemen dari  adalah

adalah  , itu

, itu  elemen vektor kolom

elemen vektor kolom  adalah

adalah  , dan

, dan  elemen dari

elemen dari  adalah

adalah  . Jadi

. Jadi  adalah

adalah  ,

,  adalah

adalah  , dan

, dan  adalah

adalah  . Solusinya adalah

. Solusinya adalah

Diagnostik

Setelah model regresi telah dibangun, mungkin penting untuk mengkonfirmasi goodness of fit model dan signifikansi statistik dari parameter yang diestimasi.Pemeriksaan goodness of fit yang umum digunakan meliputi R-squared , analisis pola residu dan pengujian hipotesis. Signifikansi statistik dapat diperiksa dengan uji-F dari kesesuaian keseluruhan, diikuti dengan uji-t dari masing-masing parameter.

Interpretasi tes diagnostik ini sangat bergantung pada asumsi model. Meskipun pemeriksaan residu dapat digunakan untuk membatalkan model, hasil uji-t atau uji - F terkadang lebih sulit untuk ditafsirkan jika asumsi model dilanggar. Misalnya, jika istilah kesalahan tidak memiliki distribusi normal, dalam sampel kecil parameter yang diestimasi tidak akan mengikuti distribusi normal dan mempersulit inferensi. Namun, dengan sampel yang relatif besar, teorema batas pusat dapat digunakan sedemikian rupa sehingga pengujian hipotesis dapat dilanjutkan dengan menggunakan perkiraan asimptotik.

Variabel dependen terbatas

Variabel dependen terbatas , yang merupakan variabel respons yang merupakan variabel kategorikal atau variabel yang dibatasi untuk jatuh hanya dalam kisaran tertentu, sering muncul dalam ekonometrik .

Variabel respon mungkin non-kontinu ("terbatas" terletak pada beberapa bagian dari garis nyata). Untuk variabel biner (nol atau satu), jika analisis dilanjutkan dengan regresi linier kuadrat-terkecil, model ini disebut model probabilitas linier . Model nonlinear untuk variabel dependen biner termasuk model probit dan logit . Model probit multivariat adalah metode standar untuk memperkirakan hubungan bersama antara beberapa variabel dependen biner dan beberapa variabel independen. Untuk variabel kategori dengan lebih dari dua nilai ada multinomial logit . Untuk variabel ordinal dengan lebih dari dua nilai, ada logit yang dipesan dan model probit yang dipesan . Model regresi yang disensor dapat digunakan ketika variabel dependen hanya kadang-kadang diamati, dan model tipe koreksi Heckman dapat digunakan ketika sampel tidak dipilih secara acak dari populasi yang diminati. Alternatif untuk prosedur tersebut adalah regresi linier berdasarkan korelasi polikorik (atau korelasi poliserial) antara variabel kategori. Prosedur seperti itu berbeda dalam asumsi yang dibuat tentang distribusi variabel dalam populasi. Jika variabel positif dengan nilai-nilai rendah dan mewakili pengulangan terjadinya suatu peristiwa, maka hitung model seperti regresi Poisson atau model binomial negatif dapat digunakan.

regresi linier

Ketika fungsi model tidak linier dalam parameter, jumlah kuadrat harus diminimalkan dengan prosedur berulang. Ini memperkenalkan banyak komplikasi yang dirangkum dalam Perbedaan antara kuadrat terkecil linier dan non-linier .

Interpolasi dan ekstrapolasi

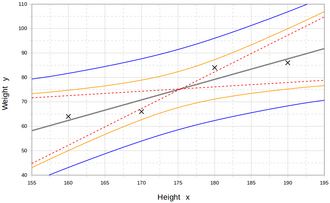

Di tengah, garis lurus terinterpolasi mewakili keseimbangan terbaik antara titik-titik di atas dan di bawah garis ini. Garis putus-putus mewakili dua garis ekstrem. Kurva pertama mewakili nilai estimasi. Kurva luar mewakili prediksi untuk pengukuran baru. [20]

Model regresi memprediksi nilai variabel Ymengingat nilai variabel X yang diketahui. Prediksi dalam kisaran nilai dalam dataset yang digunakan untuk pemasangan model dikenal secara informal sebagai interpolasi . Prediksi di luar rentang data ini dikenal sebagai ekstrapolasi . Melakukan ekstrapolasi sangat bergantung pada asumsi regresi. Semakin jauh ekstrapolasi keluar dari data, semakin banyak ruang bagi model untuk gagal karena perbedaan antara asumsi dan data sampel atau nilai sebenarnya.

Secara umum disarankan bahwa ketika melakukan ekstrapolasi, seseorang harus menyertai nilai estimasi variabel dependen dengan interval prediksi yang mewakili ketidakpastian. Interval seperti itu cenderung berkembang dengan cepat ketika nilai-nilai variabel independen bergerak di luar kisaran yang dicakup oleh data yang diamati.

Untuk alasan tersebut dan lainnya, beberapa cenderung mengatakan bahwa mungkin tidak bijaksana untuk melakukan ekstrapolasi. [21]

Namun, ini tidak mencakup set lengkap kesalahan pemodelan yang dapat dibuat: khususnya, asumsi bentuk tertentu untuk hubungan antara Y dan X. Analisis regresi yang dilakukan dengan benar akan mencakup penilaian seberapa baik formulir yang diasumsikan dicocokkan dengan data yang diamati, tetapi hanya dapat melakukannya dalam kisaran nilai dari variabel independen yang sebenarnya tersedia. Ini berarti bahwa setiap ekstrapolasi sangat bergantung pada asumsi yang dibuat tentang bentuk struktural dari hubungan regresi. Saran praktik terbaik di sini [ rujukan? ] Adalah bahwa hubungan linear-in-variabel dan linear-in-parameter tidak boleh dipilih hanya untuk kenyamanan komputasi, tetapi bahwa semua pengetahuan yang tersedia harus digunakan dalam membangun model regresi. Jika pengetahuan ini mencakup fakta bahwa variabel dependen tidak dapat pergi di luar rentang nilai tertentu, ini dapat digunakan dalam memilih model - bahkan jika dataset yang diamati tidak memiliki nilai khususnya di dekat batas tersebut. Implikasi dari langkah ini memilih bentuk fungsional yang sesuai untuk regresi bisa menjadi besar ketika ekstrapolasi dipertimbangkan. Minimal, dapat memastikan bahwa setiap ekstrapolasi yang muncul dari model yang pas adalah "realistis" (atau sesuai dengan apa yang diketahui).

Perhitungan daya dan ukuran sampel

Tidak ada metode yang disepakati secara umum untuk menghubungkan jumlah pengamatan versus jumlah variabel independen dalam model. Salah satu aturan praktis yang diduga oleh Good and Hardin adalah  dimana

dimana  adalah ukuran sampel,

adalah ukuran sampel,  adalah jumlah variabel independen dan

adalah jumlah variabel independen dan  adalah jumlah pengamatan yang diperlukan untuk mencapai presisi yang diinginkan jika model hanya memiliki satu variabel independen. [22] Misalnya, seorang peneliti sedang membangun model regresi linier menggunakan dataset yang berisi 1000 pasien (

adalah jumlah pengamatan yang diperlukan untuk mencapai presisi yang diinginkan jika model hanya memiliki satu variabel independen. [22] Misalnya, seorang peneliti sedang membangun model regresi linier menggunakan dataset yang berisi 1000 pasien (  ). Jika peneliti memutuskan bahwa lima pengamatan diperlukan untuk menentukan garis lurus secara tepat (

). Jika peneliti memutuskan bahwa lima pengamatan diperlukan untuk menentukan garis lurus secara tepat (  ), maka jumlah maksimum variabel independen yang dapat didukung model adalah 4, karena

), maka jumlah maksimum variabel independen yang dapat didukung model adalah 4, karena

Metode lain

Meskipun parameter model regresi biasanya diperkirakan menggunakan metode kuadrat terkecil, metode lain yang telah digunakan meliputi:

- Metode Bayesian , misalnya regresi linear Bayesian

- Persentase regresi, untuk situasi di mana mengurangi kesalahan persentasedianggap lebih tepat. [23]

- Penyimpangan absolut terkecil , yang lebih kuat dengan adanya outlier, yang mengarah ke regresi kuantil

- Regresi nonparametrik , membutuhkan sejumlah besar pengamatan dan intensif secara komputasi

- Optimalisasi skenario , mengarah ke model prediktor interval

- Pembelajaran metrik jarak, yang dipelajari dengan mencari metrik jarak yang bermakna di ruang input yang diberikan. [24]

Perangkat Lunak

Semua paket perangkat lunak statistik utama melakukan analisis regresi inferensi terkecil dan inferensi. Regresi linier sederhana dan regresi berganda menggunakan kuadrat terkecil dapat dilakukan dalam beberapa aplikasi spreadsheet dan pada beberapa kalkulator. Sementara banyak paket perangkat lunak statistik dapat melakukan berbagai jenis regresi nonparametrik dan kuat, metode ini kurang standar; paket perangkat lunak yang berbeda menerapkan metode yang berbeda, dan metode dengan nama yang diberikan dapat diimplementasikan secara berbeda dalam paket yang berbeda. Perangkat lunak regresi khusus telah dikembangkan untuk digunakan dalam bidang-bidang seperti analisis survei dan neuroimaging.

Lihat juga

- Kuartet Anscombe

- Kurva pas

- Teori estimasi

- Peramalan

- Fraksi varian tidak dapat dijelaskan

- Aproksimasi fungsi

- Model linier umum

- Kriging (algoritma estimasi kuadrat terkecil linier)

- Regresi lokal

- Masalah unit areal yang dapat dimodifikasi

- Splines regresi adaptif multivariat

- Distribusi normal multivarian

- Pearson koefisien korelasi momen-produk

- Varians kuasi

- Interval prediksi

- Validasi regresi

- Regresi yang kuat

- Regresi tersegmentasi

- Pemrosesan sinyal

- Regresi bertahap

- Estimasi tren

Referensi

- ^ Diperlukan Analisis Kondisi

- ^ David A. Freedman (27 April 2009). Model Statistik: Teori dan Praktek .Cambridge University Press. ISBN 978-1-139-47731-4 .

- ^ R. Dennis Cook; Sanford Weisberg Kritik dan Analisis Pengaruh dalam Regresi , Metodologi Sosiologis , Vol. 13. (1982), hlm. 313-361

- ^ AM Legendre . Nouvelles méthodes pour la détermination des orbites des comètes , Firmin Didot, Paris, 1805. "Sur la Méthode des moindres quarrés" muncul sebagai lampiran.

- ^ a b Bab 1 dari: Angrist, JD, & Pischke, JS (2008). Ekonometrika Paling Tidak Berbahaya: Sahabat Seorang Empiris . Princeton University Press.

- ^ CF Gauss. Theoria kombinasi adalah observasi erroribus minimis obnoxiae .(1821/1823)

- ^ Mogull, Robert G. (2004). Statistik Terapan Semester Kedua . Kendall / Perusahaan Penerbitan Hunt. hal. 59. ISBN 978-0-7575-1181-3 .

- ^ Galton, Francis (1989). "Kekerabatan dan Korelasi (dicetak ulang 1989)". Ilmu Statistik 4 (2): 80–86. doi : 10.1214 / ss / 1177012581 . JSTOR 2245330 .

- ^ Francis Galton . "Hukum khas keturunan", Nature 15 (1877), 492–495, 512–514, 532–533. (Galton menggunakan istilah "pembalikan" dalam makalah ini, yang membahas ukuran kacang polong.)

- ^ Francis Galton. Pidato Presiden, Bagian H, Antropologi. (1885) (Galton menggunakan istilah "regresi" dalam makalah ini, yang membahas ketinggian manusia.)

- ^ Yule, G. Udny (1897). "Tentang Teori Korelasi" . Jurnal Masyarakat Statistik Kerajaan . 60 (4): 812–54. doi : 10.2307 / 2979746 . JSTOR 2979746 .

- ^ Pearson, Karl ; Yule, GU; Blanchard, Norman; Lee, Alice (1903). "Hukum Keturunan Leluhur" . Biometrika . 2 (2): 211-236. doi : 10.1093 / biomet / 2.2.211 . JSTOR 2331683 .

- ^ Fisher, RA (1922). "Kebaikan formula formula regresi, dan distribusi koefisien regresi" . Jurnal Masyarakat Statistik Kerajaan . 85 (4): 597–612. doi : 10.2307 / 2341124 . JSTOR 2341124 . PMC 1084801 .

- ^ Ronald A. Fisher (1954). Metode Statistik untuk Pekerja Penelitian (Twelfth ed.). Edinburgh : Oliver dan Boyd. ISBN 978-0-05-002170-5 .

- ^ Aldrich, John (2005). "Fisher dan Regresi". Ilmu Statistik 20 (4): 401–417. doi : 10.1214 / 088342305000000331 . JSTOR 20061201 .

- ^ Rodney Ramcharan. Regresi: Mengapa Ekonom Terobsesi dengan Mereka?Maret 2006. Diakses 2011-12-03.

- ^ Fotheringham, A. Stewart; Brunsdon, Chris; Charlton, Martin (2002). Regresi tertimbang secara geografis: analisis hubungan yang bervariasi secara spasial(Cetak ulang ed.). Chichester, Inggris: John Wiley. ISBN 978-0-471-49616-8 .

- ^ Fotheringham, AS; Wong, DWS (1 Januari 1991). "Masalah unit areal yang dapat dimodifikasi dalam analisis statistik multivariat". Lingkungan dan Perencanaan A. 23 (7): 1025-1044. doi : 10.1068 / a231025 .

- ^ Steel, RGD, dan Torrie, JH, Prinsip dan Prosedur Statistik dengan Referensi Khusus untuk Ilmu Biologi. , McGraw Hill , 1960, halaman 288.

- ^ Rouaud, Mathieu (2013). Probabilitas, Statistik, dan Estimasi (PDF) . hal. 60.

- ^ Chiang, CL, (2003) Metode analisis statistik , World Scientific. ISBN 981-238-310-7 - halaman 274 bagian 9.7.4 "interpolasi vs ekstrapolasi"

- ^ Bagus, PI ; Hardin, JW (2009). Kesalahan Umum dalam Statistik (Dan Cara Menghindarinya) (edisi ke-3). Hoboken, New Jersey: Wiley. hal. 211. ISBN 978-0-470-45798-6 .

- ^ Tofallis, C. (2009). "Regresi Persentase Kuadrat Terkecil". Jurnal Metode Statistik Terapan Modern . 7 : 526–534. doi : 10.2139 / ssrn.1406472 . SSRN1406472 .

- ^ YangJing Long (2009). "Estimasi usia manusia dengan pembelajaran metrik untuk masalah regresi" (PDF) . Proc Konferensi Internasional tentang Analisis Gambar dan Pola Komputer: 74–82. Diarsipkan dari yang asli (PDF) pada 2010-01-08.